Ayer, Apple tuvo su gran evento, y durante la presentación del iPhone, anunciaron una nueva funcionalidad: Apple Visual Intelligence. Esta herramienta permite tomar fotos de cualquier cosa, y utiliza la inteligencia de Apple para búsquedas locales, compras, ayuda con tareas y más.

Apple está utilizando servicios como Google, ChatGPT, y posiblemente Yelp y OpenTable integrados con Apple Maps para estas funciones. Y sí, esto se parece mucho a Google Lens…

Esta parte de la presentación comienza alrededor del minuto 57, pero aquí te comparto algunas capturas de pantalla.

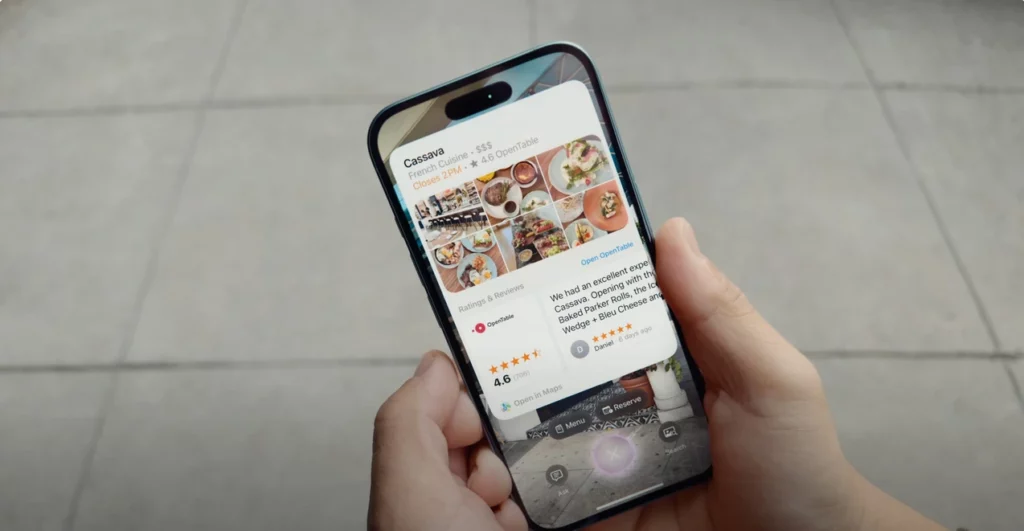

Aquí vemos a un hombre tomando una foto de la entrada de un restaurante para obtener más información sobre él, probablemente utilizando Yelp y OpenTable.

Resultados obtenidos:

En este otro ejemplo, alguien toma una foto de una bicicleta para buscar ese producto y sus precios en Google:

Los resultados parecen personalizados:

Y también ofrece ayuda con tareas utilizando ChatGPT:

Aquí tienes el video embebido en el punto de inicio, si deseas verlo:

En resumen, Apple está implementando inteligencia artificial como herramientas integradas, esencialmente como aplicaciones dentro de su ecosistema.

Conclusión:

Apple Visual Intelligence representa un paso significativo hacia la integración de IA en su ecosistema, ofreciendo a los usuarios nuevas formas de interactuar con el mundo que los rodea a través de su cámara. Esta funcionalidad, similar a Google Lens, busca facilitar las búsquedas locales, el shopping, y la ayuda en tareas académicas de una manera intuitiva.